VOXERA

Интегрированная экосистема голосового искусственного интеллекта для многомерной оценки психофизиологического состояния человека.

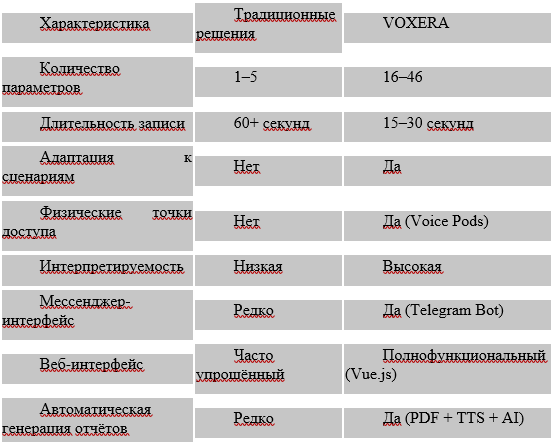

Голос человека представляет собой сложный психофизиологический биомаркер, отражающий совокупность нейромышечных, когнитивных и эмоциональных процессов. Несмотря на активное развитие методов обработки речи и аффективных вычислений (affective computing), большинство существующих решений ориентированы на узкие задачи и не обладают системной масштабируемостью для применения в различных отраслях.

В данной работе представлена VOXERA — модульная экосистема голосового искусственного интеллекта, предназначенная для многомерной оценки психофизиологического и поведенческого состояния человека на основе коротких речевых выборок (15–30 секунд). Платформа интегрирует методы цифровой обработки сигналов (DSP), машинного обучения и сценарно-ориентированной интерпретации результатов, что позволяет применять её в медицине, корпоративных HR-системах, сфере безопасности и финансовых рисках.

Подробнее об этом расскажет её создатель Всеволод ЩЕГЕЛЬСКИЙ.

В данной работе представлена VOXERA — модульная экосистема голосового искусственного интеллекта, предназначенная для многомерной оценки психофизиологического и поведенческого состояния человека на основе коротких речевых выборок (15–30 секунд). Платформа интегрирует методы цифровой обработки сигналов (DSP), машинного обучения и сценарно-ориентированной интерпретации результатов, что позволяет применять её в медицине, корпоративных HR-системах, сфере безопасности и финансовых рисках.

Подробнее об этом расскажет её создатель Всеволод ЩЕГЕЛЬСКИЙ.

- Экосистема построена вокруг четырёх технологических столпов: AI (нейронные модели), Sound (голосовой анализ), Emotion (эмоциональный интеллект) и Protection (защита данных), и разделена на три основных сегмента: B2B (корпоративный сектор), B2C (потребительские продукты) и B2G (государственный сектор), - говорит он. - Важной частью экосистемы является Voxera Bot — Telegram-бот, построенный на базе Laravel 11 и Vue.js 3, который обеспечивает доступный интерфейс для массового пользователя и демонстрирует возможности голосового ИИ через мессенджер-платформу.

- Что может, применительно к вашей системе, рассказать о человеке его голос?

- Производство человеческой речи является результатом сложного взаимодействия физиологических, нейронных и когнитивных механизмов (Scherer, 2003). Изменения эмоционального состояния, уровня стресса, утомления или когнитивной нагрузки отражаются в работе дыхательной системы, мышечном тонусе голосового аппарата и механизмах нейронной регуляции, что приводит к измеримым изменениям акустических характеристик речи (Cowie et al., 2001).

Современные исследования показывают, что акустические параметры речи коррелируют с психоэмоциональным состоянием человека (Schuller et al., 2013; Eyben et al., 2016). Исследования Техасского университета (2021) подтвердили, что психологические черты могут быть предсказаны на основе лингвистических и акустических данных голоса с высокой степенью точности.

Однако, большинство существующих решений для анализа голоса страдают от ориентации на одну узкую задачу, плохой адаптации к различным контекстам применения, отсутствия инфраструктурного подхода, требования длительных записей голоса (более 60 секунд) и отсутствия удобных пользовательских интерфейсов для массового применения.

- Так для чего же разработана ваша экосистема VOXERA, какие задачи она моделирует и какие предлагает решения?

- Цель разработки VOXERA заключалась в создании масштабируемой экосистемы голосового ИИ, способной выполнять многомерную оценку психофизиологического состояния по коротким голосовым сессиям (15–30 секунд), интерпретировать результаты в зависимости от прикладного сценария и функционировать как цифровая и киберфизическая платформа через API, веб-интерфейсы, мессенджеры и физические точки доступа.

VOXERA реализована как модульная распределённая система, включающая шесть логических уровней обработки данных.

- Что может, применительно к вашей системе, рассказать о человеке его голос?

- Производство человеческой речи является результатом сложного взаимодействия физиологических, нейронных и когнитивных механизмов (Scherer, 2003). Изменения эмоционального состояния, уровня стресса, утомления или когнитивной нагрузки отражаются в работе дыхательной системы, мышечном тонусе голосового аппарата и механизмах нейронной регуляции, что приводит к измеримым изменениям акустических характеристик речи (Cowie et al., 2001).

Современные исследования показывают, что акустические параметры речи коррелируют с психоэмоциональным состоянием человека (Schuller et al., 2013; Eyben et al., 2016). Исследования Техасского университета (2021) подтвердили, что психологические черты могут быть предсказаны на основе лингвистических и акустических данных голоса с высокой степенью точности.

Однако, большинство существующих решений для анализа голоса страдают от ориентации на одну узкую задачу, плохой адаптации к различным контекстам применения, отсутствия инфраструктурного подхода, требования длительных записей голоса (более 60 секунд) и отсутствия удобных пользовательских интерфейсов для массового применения.

- Так для чего же разработана ваша экосистема VOXERA, какие задачи она моделирует и какие предлагает решения?

- Цель разработки VOXERA заключалась в создании масштабируемой экосистемы голосового ИИ, способной выполнять многомерную оценку психофизиологического состояния по коротким голосовым сессиям (15–30 секунд), интерпретировать результаты в зависимости от прикладного сценария и функционировать как цифровая и киберфизическая платформа через API, веб-интерфейсы, мессенджеры и физические точки доступа.

VOXERA реализована как модульная распределённая система, включающая шесть логических уровней обработки данных.

Первый уровень - сбор данных. Голосовые данные поступают через множественные каналы: Мобильные и веб-приложения, интеграционные API (контакт-центры, корпоративные системы), физические точки доступа — Voice Pods (голосовые кабины), мессенджер-интерфейсы — Telegram-бот (Voxera Bot) и веб-интерфейс "Переговорная будка" (Booth) для загрузки аудиофайлов.

Каждая сессия сопровождается метаданными: язык, длительность, сценарий использования, временная метка, источник данных.

Второй уровень - предварительная обработка сигналов (DSP). Сырой аудиосигнал проходит нормализацию амплитуды, конвертацию в унифицированный формат (WAV) с использованием FFmpeg, шумоподавление (Spectral Subtraction, Wiener Filtering), детекцию речевой активности (Voice Activity Detection, VAD) и сегментацию речи на фонетические единицы.

Параллельно рассчитываются показатели качества записи (SNR, уровень искажений).

Третий уровень - извлечение признаков. С применением методов цифровой обработки сигналов вычисляются временные признаки(фундаментальная частота (F0) и её стандартное отклонение, Jitter (микродрожание частоты), Shimmer (вариации амплитуды) и длительность и частота пауз) и спектральные признаки (MFCC (Mel-Frequency Cepstral Coefficients, спектральный центроид и спектральная энтропия и HNR (Harmonic-to-Noise Ratio)). А также просодические признаки (темп речи (слова/минута), интонационные контуры и энергетические характеристики).

Четвёртый уровень - ядро машинного обучения (ML Core). Извлечённые признаки обрабатываются ансамблем моделей машинного обучения. Это нейросетевые модели (PyTorch) (CNN для спектральных признаков, LSTM для временных последовательностей и трансформеры для контекстного анализа). Классические алгоритмы (Scikit-learn) включают в себя Random Forest для интерпретируемых оценок, SVM для классификации и XGBoost для ансамблевого обучения.

Используются следующие методы обнаружения аномалий: Isolation Forest, One-Class SVM, Autoencoder для выявления отклонений.

Пятый уровень - сценарная интерпретация (Decision Engine). Результаты анализа агрегируются и интерпретируются с учётом контекста применения (медицина, HR, безопасность, финансы), заданных правил принятия решений и пороговых значений для каждой шкалы.

И шестой уровень - представление и интеграция. На нём формируются визуальные отчёты для конечных пользователей, PDF-документы с результатами анализа, аудио-озвучка результатов через Text-to-Speech, машинно-читаемые результаты (JSON, XML) для интеграции и API для real-time доступа.

- Но ведь человеческий голос во многом многопланен и разнообразен. Какме методы использует ваша платформа?

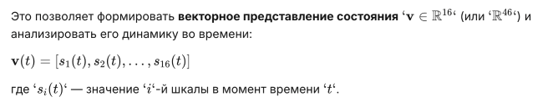

- Ключевой методологический принцип VOXERA заключается в отказе от одноосевой классификации. Вместо этого используется многомерная модель, основанная на независимых аналитических шкалах, каждая из которых отражает отдельный аспект голосового поведения.

Всего используются 16 базовых аналитических шкал. Перечислю:

- Стабильность/нестабильность голоса

- Вокальное напряжение

- Эмоциональная вариативность

- Эмоциональная динамика

- Темп речи

- Ритмические характеристики

- Дыхательные паттерны

- Структурность артикуляции

- Когнитивная нагрузка

- Уровень энергии

- Монотонность/выразительность

- Контроль голоса

- Резонансные характеристики

- Артикуляционная чёткость

- Паузация

- Вокальная плотность

Хранение данных осуществляется в гибридной архитектуре:

Технологический стек:

- Backend (ML Core): Python (Django, FastAPI), Go

- ML/DS: PyTorch, NumPy, Pandas, SciPy, Scikit-learn

- Аудио: Librosa, Pydub, Praat, FFmpeg

- Контейнеризация: Docker, Kubernetes

Это позволяет:

- Отслеживать изменения состояния во времени через similarity search

- Сравнивать текущую сессию с базовой линией

- Реализовывать антифрод- и security-сценарии

- Работать без хранения сырого аудио (privacy-preserving)

- Voxera Bot представляет собой Telegram-бот, обеспечивающий массовый доступ к возможностям голосового ИИ через популярную мессенджер-платформу. Бот позволяет пользователям отправлять голосовые сообщения или аудиофайлы для анализа, получать подробные отчёты о психотипе и психоэмоциональном состоянии, просматривать историю всех запросов и результатов, загружать PDF-отчёты и прослушивать результаты через Text-to-Speech озвучку.

Архитектурно Voxera Bot построен как full-stack приложение с чёткой сепарацией backend и frontend компонентов.

Поясню для специалистов и читателей, разбирающихся в структуре искусственного интеллекта.

Laravel 11 выбран в качестве основного backend-фреймворка благодаря:

- Элегантной архитектуре MVC

- Встроенной системе миграций и ORM (Eloquent)

- Мощной системе очередей (Queues) для асинхронной обработки

- Интеграции с внешними API

- Поддержке множественных баз данных (SQLite, MySQL, PostgreSQL)

- Telegram Bot API Integration

- Обработка входящих сообщений и голосовых файлов

- Управление диалогами и состояниями пользователя

- Отправка результатов анализа

- Audio Processing Pipeline

- Конвертация аудио в WAV формат через FFmpeg

- Отправка обработанных файлов в ML API

- Управление временными файлами

- ML API Client

- HTTP-клиент для взаимодействия с внешним ML API (VOXERA Core)

- Обработка JSON-ответов с результатами анализа

- Retry-логика и обработка ошибок

- Report Generation

- Автоматическая генерация PDF-отчётов с результатами

- AI-генерация текстовых описаний документов

- Text-to-Speech озвучка результатов

- User Management & Analytics

- Система аутентификации и авторизации

- Хранение истории запросов пользователей

- Статистика использования

- Admin Panel

- Управление пользователями

- Мониторинг системы

- Просмотр аналитики

- Поддержка SQLite (для разработки), MySQL и PostgreSQL (для production)

- Eloquent ORM для работы с данными

- Миграции для версионирования схемы БД

- Frontend (Vue.js 3 + Vite)

Основные компоненты Vue.js приложения:

- Пользователь отправляет голосовое сообщение или аудиофайл в Telegram-бот. Система скачивает аудио через Telegram Bot API, конвертирует в WAV формат (FFmpeg), отправляет в ML API для анализа, получает результаты (16–46 параметров) и формирует отчёт с интерпретацией.

- Audio Upload Interface

- Drag-and-drop загрузка аудиофайлов

- Запись голоса через браузер (Web Audio API)

- Предпросмотр загруженных файлов

- Analysis Dashboard

- Визуализация результатов анализа

- Интерактивные графики и диаграммы

- Многомерное представление шкал

- User Profile & History

- Личный кабинет пользователя

- История всех анализов

- Сравнение результатов во времени

- Real-time Updates

- WebSocket-соединение для отслеживания статуса обработки

- Прогресс-бары и индикаторы загрузки

- Vite — современный сборщик и dev-сервер

- Axios — HTTP-клиент для взаимодействия с Laravel API

- Chart.js / D3.js — визуализация данных

- Vuex / Pinia — управление состоянием приложения

- Пользователь отправляет голосовое сообщение или аудиофайл в Telegram-бот. Система скачивает аудио через Telegram Bot API, конвертирует в WAV формат (FFmpeg), отправляет в ML API для анализа, получает результаты (16–46 параметров) и формирует отчёт с интерпретацией.

Типы анализа:

- Психотип личности (на основе голосовых характеристик)

- Психоэмоциональное состояние (стресс, тревога, энергия)

- Поведенческие паттерны (стабильность, контроль, вариативность)

- Параллельно с Telegram-ботом пользователи могут использовать веб-интерфейс Booth, построенный на Vue.js:

- Загрузка аудиофайлов любого формата

- Запись голоса напрямую через браузер

- Расширенная визуализация результатов

- Экспорт отчётов в PDF

- Сравнение нескольких сессий

- Генерирует PDF-отчёт с результатами

- Создаёт текстовое описание результатов через AI

- Озвучивает результаты через Text-to-Speech

- Отправляет все материалы пользователю

- Общая оценка психоэмоционального состояния

- Детализация по 16 шкалам

- Графики и визуализации

- Рекомендации и интерпретация

- История анализов — доступ ко всем предыдущим сессиям

- Динамика изменений — отслеживание состояния во времени

- Статистика — агрегированные данные по пользователю

- Сравнительный анализ — сопоставление разных сессий

- Управлению пользователями (блокировка, удаление, роли)

- Мониторингу системы (количество запросов, нагрузка)

- Аналитике использования (популярные функции, время обработки)

- Управлению контентом (настройка шаблонов отчётов)

Voxera Bot взаимодействует с VOXERA ML Core через RESTful API.

Процесс обработки запроса:

- Пользователь отправляет голосовое сообщение → Telegram Bot API

- Laravel получает webhook → скачивает аудио

- FFmpeg конвертирует аудио → WAV формат

- Laravel отправляет POST-запрос → ML API

- ML Core обрабатывает аудио → DSP → Feature Extraction → ML Inference

- ML Core возвращает результаты → JSON

- Laravel генерирует отчёт → PDF + TTS + AI description

- Отправка результатов пользователю → Telegram

Разделение ответственности:

- Laravel — бизнес-логика, интеграции, управление данными

- Vue.js — интерактивный пользовательский интерфейс

- ML Core (Python) — тяжёлые вычисления и ML-инференс

- Горизонтальное масштабирование Laravel через load balancers

- Асинхронная обработка через Laravel Queues

- Кэширование через Redis

- CDN для статических ресурсов Vue.js

- Поддержка множественных интерфейсов (Telegram, Web, API)

- Лёгкая интеграция с другими мессенджерами (WhatsApp, Viber)

- Модульная архитектура для добавления новых функций

- Экспериментальные и пилотные внедрения показали, что VOXERA способна формировать устойчивые оценки психофизиологического состояния на основе голосовых фрагментов длительностью 15–30 секунд.

Внутренние исследования с участием более 3000 респондентов демонстрируют:

- Диапазон точности: 70–90% в зависимости от задачи и психотипа

- Время обработки: < 2 секунд для одной сессии

- Поддержка языков: русский, английский, казахский (с возможностью расширения)

- Валидация результатов: Положительные отзывы участников подтверждают высокий уровень точности системы. Исследования показали, что использование голоса для психологического профилирования поддерживается научными патентами и технологиями (University of Texas, 2021).

- Более 5.000 пользователей зарегистрировались в системе

- Более 15.000 голосовых анализов выполнено

- Средняя длительность сессии: 22 секунды

- Retention rate: 45% пользователей возвращаются для повторного анализа

- Средняя оценка пользователей: 4.6/5

B2B: Корпоративный сектор

Voxera Office:

Voxera Classic:

Voxera Healthcare:

- Результаты исследования подтверждают, что голосовой ИИ наиболее эффективен при использовании многомерных моделей и сценарно-ориентированной интерпретации. Подход VOXERA позволяет разделить этапы извлечения признаков и принятия решений, обеспечивая адаптацию под различные отрасли без переработки базового ML-ядра.

Voxera Office:

- Умные звукоизолированные кабины

- ИИ-анализ эмоций голоса для интеграции с HR-системами

- Индекс выгорания сотрудников

- Индивидуальные брендированные ИИ-решения для крупных корпоративных заказчиков

Voxera Classic:

- Персональные звуковые капсулы для домашнего использования

- ИИ-релаксация, медитация, терапия

- ИИ-управляемый трекер настроения

- Программы ментального здоровья

- Массовый доступ к голосовому анализу через мессенджер

- Удобный интерфейс для регулярного мониторинга состояния

Voxera Healthcare:

- Решения для больниц — снятие стресса

- Анализ эмоций для врачей и пациентов

- Капсулы релаксации в школах и университетах

- Результаты исследования подтверждают, что голосовой ИИ наиболее эффективен при использовании многомерных моделей и сценарно-ориентированной интерпретации. Подход VOXERA позволяет разделить этапы извлечения признаков и принятия решений, обеспечивая адаптацию под различные отрасли без переработки базового ML-ядра.

Ключевые преимущества:

- Модульность архитектуры — возможность добавления новых модулей без изменения ядра

- Масштабируемость — горизонтальное масштабирование через контейнеризацию

- Интерпретируемость результатов — шкальная модель вместо "чёрного ящика"

- Киберфизическая интеграция — сочетание цифровых и физических точек доступа

- Множественные интерфейсы — Telegram, Web, API, Voice Pods

- Технологическая инновация Voxera Bot

Преимущества full-stack подхода:

- Единая кодовая база для веб и API

- Быстрая разработка благодаря Laravel ecosystem

- Интерактивный UX благодаря Vue.js

- Лёгкая интеграция с ML Core через RESTful API

- Laravel Queues для асинхронной обработки

- Redis для кэширования и session management

- Поддержка микросервисной архитектуры

- Hot Module Replacement (Vite)

- Eloquent ORM для работы с данными

- Встроенная система тестирования (PHPUnit, Jest)

Вместе с тем, остаются вызовы, связанные с:

• Расширением валидации на более крупных и разнообразных выборках

• Межъязыковой адаптацией — учёт фонетических и культурных особенностей

• Этическими аспектами применения — приватность, согласие, прозрачность

• Регуляторными требованиями — соответствие GDPR, HIPAA и другим стандартам

Дальнейшие исследования будут направлены на:

• Углубление отраслевой адаптации (медицина, образование, безопасность)

• Интеграцию с другими биометрическими модальностями (ЭЭГ, пульс, кожно-гальваническая реакция)

• Формализацию этических стандартов внедрения

• Расширение функциональности Voxera Bot (интеграция с другими мессенджерами, голосовые ассистенты)

• Разработку мобильных приложений (iOS, Android) на базе Vue.js / React Native

- И, в завершение нашей беседы, полагаю, вы резюмируете ваши изыскания и расскажете нашим читателям – какова сфера применения экосистемы VOXERA.

- VOXERA демонстрирует переход от отдельных алгоритмов анализа речи к полноценной экосистеме голосового искусственного интеллекта. Рассмотрение голоса как психофизиологического биомаркера позволяет создавать масштабируемые решения для раннего выявления рисков и поддержки принятия решений в различных отраслях.

• Углубление отраслевой адаптации (медицина, образование, безопасность)

• Интеграцию с другими биометрическими модальностями (ЭЭГ, пульс, кожно-гальваническая реакция)

• Формализацию этических стандартов внедрения

• Расширение функциональности Voxera Bot (интеграция с другими мессенджерами, голосовые ассистенты)

• Разработку мобильных приложений (iOS, Android) на базе Vue.js / React Native

- И, в завершение нашей беседы, полагаю, вы резюмируете ваши изыскания и расскажете нашим читателям – какова сфера применения экосистемы VOXERA.

- VOXERA демонстрирует переход от отдельных алгоритмов анализа речи к полноценной экосистеме голосового искусственного интеллекта. Рассмотрение голоса как психофизиологического биомаркера позволяет создавать масштабируемые решения для раннего выявления рисков и поддержки принятия решений в различных отраслях.

Экосистема, построенная вокруг четырёх технологических столпов (AI, Sound, Emotion, Protection) и трёх сегментов (B2B, B2C, B2G), открывает новые возможности для:

- Медицины — раннее выявление стресса, выгорания, психических расстройств

- Корпоративных систем — оптимизация HR-процессов, снижение текучести кадров

- Безопасности — мониторинг состояния сотрудников в профессиях высокого риска

- Финансов — дополнительный сигнал в антифрод-системах

- Государственного сектора — поддержка реабилитации, образования, здравоохранения

- Массового потребителя — доступ к голосовому анализу через Telegram и веб-интерфейсы

Результаты пилотных исследований с участием более 3000 респондентов подтверждают эффективность подхода (точность 70–90%). Дальнейшее развитие экосистемы будет направлено на расширение языковой поддержки, углубление отраслевой адаптации и формализацию этических стандартов.